Les tests paramétriques sont utilisés pour les cas suivants :

- Données quantitatives

- Variable continue

- Lorsque les données sont mesurées sur des échelles de mesure approximatives d'intervalle ou de rapport.

- Quand les données doivent suivre la distribution normale

Types de tests paramétriques

- t-test (n< 30), qui est en outre classé en 1 échantillon et 2 échantillons

- Anova (analyse de la variance) - Anova unidirectionnelle, Anova bidirectionnelle

- Corrélation r de Pearson

- Test Z pour les grands échantillons (n> 30)

Test T de l'étudiant

Ce test a été développé par le professeur WSGossett en 1908, qui a publié des articles statistiques sous le pseudonyme de « Student ». Ainsi, le test est connu sous le nom de test t de Student.

Indications pour le test :

1.Lorsque les échantillons sont petits.

2.Les écarts de population ne sont pas connus.

Utilisations :

1. Comparer deux moyennes de petits échantillons indépendants

2. Comparer la moyenne de l'échantillon et la moyenne de la population

3. Comparer deux proportions de petits échantillons indépendants.

Hypothèses :

1. Les échantillons sont sélectionnés au hasard.

2. Les données utilisées sont quantitatives.

3. La variable suit la distribution normale.

4. La variance de l'échantillon est généralement la même dans les deux groupes à l'étude

.

Un test t compare la différence entre deux moyennes de groupes différents pour déterminer si la différence est statistiquement significative.

T-tests t de Student à différentes fins :

- test t pour un échantillon

- test t pour deux échantillons non appariés

- test t pour deux échantillons appariés

UN ÉCHANTILLON T-TEST

- Lorsque nous comparons la moyenne d'un seul groupe d'observations avec une valeur spécifiée.

- Dans un échantillon de test t, nous connaissons la moyenne de la population. Nous tirons un échantillon aléatoire de la population, puis comparons la moyenne de l'échantillon avec la moyenne de la population et prenons une décision statistique quant à savoir si la moyenne de l'échantillon est différente de la population.

Calculs :

Maintenant, nous comparons la valeur calculée avec la valeur du tableau à un certain niveau de signification (généralement 5% ou 1%)

Si la valeur absolue de 't' obtenue est supérieure à la valeur du tableau, rejetez l'hypothèse nulle et si elle est inférieure à la valeur du tableau, l'hypothèse nulle peut être acceptée.

Test t à deux échantillons non apparié

- Comparer deux moyennes de deux échantillons

- Deux échantillons aléatoires indépendants proviennent des populations normales ayant une variance inconnue ou la même

- Nous testons l'hypothèse nulle, selon laquelle les moyennes des deux populations sont identiques par rapport à une hypothèse alternative unilatérale ou bilatérale appropriée.

Hypothèses :

1. Les échantillons sont aléatoires et indépendants les uns des autres.

2. La distribution de la variable dépendante est normale.

3. Les écarts sont égaux dans les deux groupes.

Calculs :

Ici , Xbar_ ₁ et Xbar_ ₂ sont les moyennes de l'échantillon, s² est la variance de l'échantillon regroupé, n1 et n2 sont les tailles d'échantillon et t est un quantile de Student-t avec n1 + n2–2 degrés de liberté.

T-TEST APPARIÉ À DEUX ÉCHANTILLONS

- Utilisé lorsque nous avons apparié les données d'observations d'un seul échantillon, lorsque chaque individu donne une paire d'observations.

- Les mêmes individus sont étudiés plus d'une fois dans des circonstances différentes - des mesures effectuées sur les mêmes personnes avant et après les interventions.

Hypothèses :

1. La variable de résultat doit être continue.

2. La différence entre les mesures pré-post doit être normalement distribuée.

Calculs :

Ici, d = différence entre deux échantillons X1 et X2, dbar = moyenne de d, Sd = écart type de la différence, n = taille de l'échantillon.

Maintenant, comment comparer plus de deux groupes signifie ??

Au lieu d'utiliser une série de comparaisons individuelles comme nous le faisons dans le test t, nous examinons les différences entre les groupes à travers une analyse qui considère la variation entre tous les groupes à la fois. • c'est-à-dire ANALYSE DE VARIANCE

Analyse de la variance (ANOVA)

- Donné par Sir Ronald Fisher

- L'objectif principal des modèles statistiques est d'expliquer la variation des mesures.

- Le modèle statistique impliquant un test de significativité de la différence des valeurs moyennes de la variable entre deux groupes est le test de Student. S'il y a plus de deux groupes, le modèle statistique approprié est l'Analyse de Variance (ANOVA)

Hypothèses :

1.La population de l'échantillon peut être facilement rapprochée de la distribution normale.

2. Toutes les populations ont le même écart type.

3. Les individus de la population sont sélectionnés au hasard.

4. Échantillons indépendants.

- L'ANOVA compare la variance au moyen d'un rapport simple, appelé F-Ratio ,

F= (Variance entre les groupes) / (Variance au sein des groupes) . - Les statistiques F résultantes sont ensuite comparées à la valeur critique de F (critique) , obtenue à partir des tables F de la même manière que cela a été fait avec 't'.

- Si la valeur calculée est supérieure à la valeur critique pour le niveau approprié de α , l'hypothèse nulle sera rejetée.

Le test F est donc un test du Ratio des Variances . Les tests F peuvent également être utilisés seuls, indépendamment de la technique ANOVA , pour tester des hypothèses sur les variances.

Dans l' ANOVA , le test F est utilisé pour établir s'il existe une différence statistiquement significative dans les données testées.

L'ANOVA est en outre divisée en :

* ANOVA à une voie

* ANOVA à deux voies

ANOVA à sens unique

Si les différents groupes expérimentaux diffèrent en termes d'un seul facteur à la fois, une ANOVA à sens unique est utilisée.

Par exemple, une étude pour évaluer l'efficacité de quatre antibiotiques différents sur S Sanguis.

ANOVA bidirectionnelle

Si les différents groupes diffèrent en termes de deux facteurs ou plus à la fois, alors une ANOVA à deux voies est effectuée.

Par exemple, une étude pour évaluer l'efficacité de quatre antibiotiques différents sur S Sanguis dans trois groupes d'âge différents.

Coefficient de corrélation de Pearson

- La corrélation est une technique permettant d'étudier la relation entre deux variables quantitatives continues

- Le coefficient de corrélation de Pearson (r) est une mesure de la force de l'association entre les deux variables.

Hypothèses :

1. Les sujets sélectionnés pour l'étude avec une paire de valeurs X et Y sont choisis avec une procédure d'échantillonnage aléatoire.

2. Les

deux variables X et Y sont continues. 3. Les deux variables X et Y sont supposées suivre une distribution normale.

Étapes :

* La première étape de l'étude de la relation entre deux variables continues consiste à tracer un nuage de points des variables pour vérifier la linéarité.

*Le coefficient de corrélation ne doit pas être calculé si la relation n'est pas linéaire.

*À des fins de corrélation uniquement, peu importe sur quel axe les variables sont tracées.

Cependant, classiquement, la variable indépendante est tracée sur l'axe X et la variable dépendante sur l'axe Y.

Plus la dispersion des points est proche d'une ligne droite, plus la force d'association entre les variables est élevée.

Types de corrélation :

Corrélation positive parfaite r=+1

Corrélation positive partielle 0<r<+1

Corrélation négative parfaite r=-1

Corrélation négative partielle 0>r>-1

Aucune corrélation r=0

Test Z

- Ce test est utilisé pour tester la différence de signification entre deux moyennes (n>30).

Hypothèses :

1. L'échantillon doit être sélectionné au hasard.

2.Les données doivent être quantitatives. 3.Les échantillons

doivent être supérieurs à 30.

4.Les données doivent suivre une distribution normale.

5.Les variances d'échantillon devraient être presque les mêmes dans les deux groupes d'étude.

Remarque :

• Si l'écart type des populations est connu, un test Z peut être appliqué même si l'échantillon est inférieur à 30.

Indications :

*Pour comparer la moyenne de l'échantillon avec la moyenne de la population.

*Pour comparer deux moyennes d'échantillons.

*Pour comparer la proportion de l'échantillon avec la proportion de la population.

*Pour comparer deux proportions d'échantillons.

Étapes :

1. Définir le problème

2. Énoncer l'hypothèse nulle (H0) par rapport à l'hypothèse alternative (H1)

3. Trouver la valeur Z , Z= (Moyenne observée)/(Erreur standard moyenne) .

4. Fixation du niveau de signification

5. Comparaison de la valeur Z calculée avec la valeur du tableau Z au niveau de signification correspondant.

Si la valeur Z observée est supérieure à la valeur Z théorique, Z est significatif, nous rejetons l'hypothèse nulle et acceptons l'hypothèse alternative.

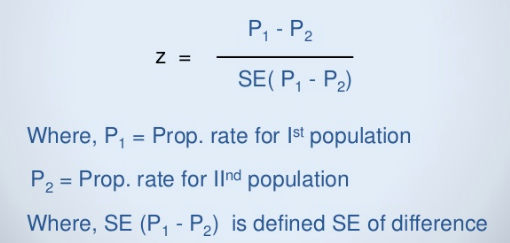

Z- TEST DE PROPORTIONNALITÉ

- Utilisé pour tester la différence significative entre deux proportions.

Calculs :

Tests Z unilatéral et bilatéral

- Les valeurs Z de chaque côté de la moyenne sont calculées comme +Z ou comme -Z.

• Un résultat supérieur à la différence entre la moyenne de l'échantillon donnera +Z et un résultat inférieur à la différence entre la moyenne donnera -Z.

Par exemple pour le test bilatéral :

dans un test de signification, lorsque l'on veut déterminer si le QI moyen des enfants malnutris est différent de celui des enfants bien nourris et ne précise pas supérieur ou inférieur, la valeur P d'un groupe expérimental inclut les deux côtés de résultats extrêmes aux deux extrémités de l'échelle, et le test est appelé test bilatéral.

Par exemple, pour

un test unilatéral : dans un test de signification lorsque l'on veut savoir spécifiquement si un résultat est plus grand ou plus petit que ce qui se produit par hasard, le niveau significatif ou la valeur P ne s'appliquera qu'à la fin relative, par exemple si nous voulons savoir si le malnutri ont un QI moyen inférieur à celui des bien nourris, le résultat se situera à une extrémité (queue) de la distribution, et le test est appelé test à une seule queue.

Conclusion

- Les tests de signification jouent un rôle important dans la transmission des résultats de toute recherche et le choix d'un test statistique approprié est donc très important car il décide du sort des résultats de l'étude.

- Par conséquent, l'accent mis sur les tests de signification dans la recherche clinique doit être tempéré par la compréhension qu'ils sont des outils d'analyse des données et ne doivent jamais être utilisés comme substitut à une interprétation éclairée des résultats.